So, die Koffer sind gepackt und los geht’s nach Las Vegas. In der nevadischen Wüste steigt ab dem 5. Januar die 50. Consumer Electronics Show, auf noch mehr Fläche, mit noch mehr Ausstellern und noch mehr Besuchern. Aus praktisch allen Technologiebereichen – von A wie Autos bis Z wie Zubehör – werden Produkte vorgestellt, die auch nur irgendwie durch Elektronik smarter gemacht werden können. Die Digitalisierung des Lebens – hier feiert sie ihr Hochamt.

Gut, dass das Riviera Hotel und Casino abgerissen wurde – so entstanden noch zusätzliche Freiflächen für Außendemos, denn Drohnen und autonome Fahrzeuge sind längst nicht nur als Designstudien vorhanden, sondern werden im praktischen Betrieb vorgeführt. Hyundai plant sogar, die Messebesucher in Selbstfahrern den Strip rauf und runter zu kutschieren. Die ersten Drohnen, die groß und sicher genug sind, dass sie Menschen transportieren können, sind ebenfalls zu sehen.

Dabei muss man in diesem Jahr die Anreise schon früher planen, denn während die CES zwar offiziell erst am 5. ihre Tore öffnet, gibt es zahllos Pre-CES Events, auf denen die Anbieter ihr Tischfeuerwerk an Produktankündigungen schon vor den eigentlichen Messetagen abfeuern wollen. Zu den eifrigsten Vorankündigern gehört Samsung. Das Unternehmen, das zuletzt mit brennenden Smartphones auf sich aufmerksam gemacht hat, ist in allen Technologiebereichen mit Produktneuvorstellungen dabei. Von TV über Audio bis zu Smartphones kommt Samsung praktisch jeden Tag mit Bahnbrechendem auf die Bühne.

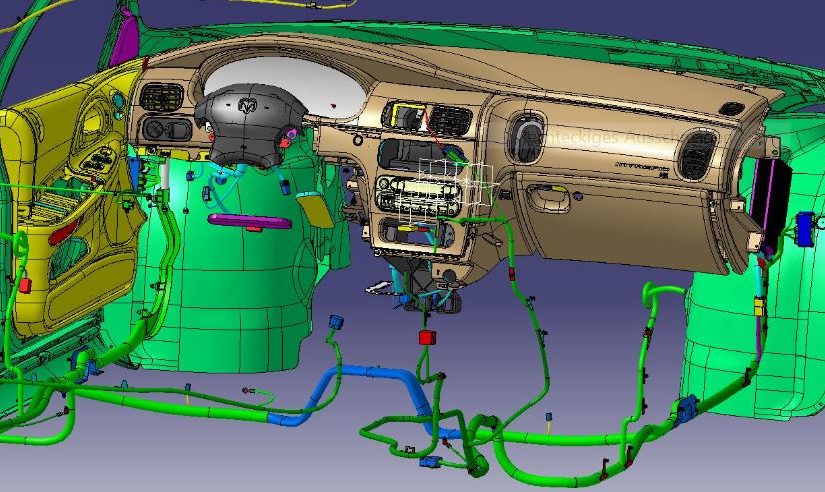

Interessant ist, dass inzwischen nicht nur die Geräte auf der CES ihren Auftritt haben. Sondern auch die Inhalte, die dem Ganzen überhaupt erst ihren Sinn beisteuern, werden in Las Vegas präsentiert. Das gilt insbesondere für Systeme zur Darstellung virtueller Realitäten, die als Augmented Reality längst Einzug ins Berufsleben von Entwicklern, Planern und Analysten gefunden haben. Doch um vor allem im Konsumermarkt voranzukommen, müssen die Anbieter mit Content rüberkommen. Das sind in erster Linie natürlich neue Spiele-Varianten, deren Komplexität und Spielwelt nur noch mit aufgesetzter VR-Brille zu erfassen sind. Aber auch Hollywood hat seinen Ausstoß an 3D-Videos in virtueller Realität auf dem Schirm. Und mehr noch: Die Anbieter von Freizeitvergnügen sehen in VR-Welten eine natürliche Erweiterung ihres Erlebnisangebots. Demnach können Besucher eines Freizeitparks auch schon im Vorfeld ihres Besuchs die Fahrt in der Achterbahn erleben. Und auch auf Kreuzfahrten, auf denen es ja weniger aufregend zugeht als in einem Fahrgeschäft, peppen die Reedereien ihre Angebote durch virtuelle Realitäten auf. Da kann der Landgang schon mal hinter der VR-Brille vorweggenommen werden.

Die 50. CES wird ihrem Image als Spaßmesse mehr und mehr gerecht. Die Messestände gewähren einen Eindruck von einem Leben, in dem uns Roboter in der digitalisierten Produktion längst die Arbeit abgenommen haben und wir auf die Hilfe von anderen Robotern und Computern angewiesen sind, um uns in unserer Freizeit vor Langeweile zu bewahren.

Doch es gibt auch die seriöse CES, die sich zwar mit der Leichtigkeit eines Spielerparadieses neuen Themen zuwendet, aber dabei einen ernsthaften Beitrag zum digitalen Leben leisten will: vor allem rund um die Themen im Gesundheitswesen zeigt die CES nun Flagge. Das beginnt selbstverständlich bei den Smartwatches, die uns dabei helfen, das tägliche Fitnesstraining zu absolvieren. Wearables, also wie Kleidung zu tragende intelligente Geräte, gibt es inzwischen schon für die Überwachung von nahezu jeder Körperfunktion – von der Blutdruckmessung, über die Ermittlung des Insulinbedarfs bis zur Überwachung von lebenserhaltenden Apparaten greift die CES ins medizinische Fach.

Es sind diese stärker auf den gesellschaftlichen und wirtschaftlichen Nutzen ausgelegten Entwicklungen der Digitalisierung, die die Domäne der CeBIT waren (und sind) und die jetzt allmählich auch in Las Vegas zu bestaunen sind. Diese Zweiteilung in Lifestyle (CES) und Informationswirtschaft (CeBIT) hat sich lange bewährt. Nun wird sie verwischt – wie alles, was vom digitalen Wandel berührt wird. Ein wenig mehr Infotainment würde der CeBIT in Hannover freilich auch gut tun.