Befinden wir uns noch in Gegenwart der Zukunft oder schon in der Zukunft, die wir gegenwärtig vorhersagen? Zu ähnlichen chrono-philosophischen Fragestellungen mag kommen, wer sich die zehn IT-Trends zu Gemüte führt, von denen die Auguren der Gartner Group glauben, dass sie vor allen anderen Trends das Jahr 2019 beeinflussen werden. Dabei haben die zehn Megatrends, die für das Jahr 2018 nach Ansicht von Gartner entscheidend gewesen sein sollten, noch kaum ihre Wirkung entfaltet. Aber bis zum Jahreswechsel sind es ja auch noch gut 60 Tage…

Denn kaum ein Unternehmen hat tatsächlich angefangen, seine Produktionsmaschinen und Produkte so mit Sensoren auszustatten, dass bei vollem Ernst von einem „digitalen Zwilling“ die Rede sein könnte, also einem genauen virtuellen Abbild der Realität, das durch die Daten entsteht, die von der Realität erzeugt werden. Jetzt aber spricht Gartner davon, dass es Unternehmen 2019 „leicht fallen „ werde, eine solche „Digital Twin“-Strategie umzusetzen. Bis zum Jahr 2020 sollen 20 Milliarden IP-Adressen im Internet der Dinge aktiv sein, die die Voraussetzung für den digitalen Zwilling von Milliarden Dingen sein werden. Sie werden durch die Daten, die sie sammeln, immer smarter und helfen dabei, das zukünftige Verhalten der Dinge zu simulieren.

Das greift bereits tief in die Trickkiste der künstlichen Intelligenz hinein, die dafür sorgen wird, dass die Dinge im Internet immer stärker autonom agieren und damit die Automatisierung auf einen neuen Level der Selbständigkeit bringen werden. Dabei werden auch die Methoden des Machine Learnings immer weiter genutzt, um tiefergehende Analysen zu ermöglichen, auf deren Basis dann Maschinen ihre Entscheidungen treffen. Dabei wird der Prozess der Datenaufbereitung, der Datenauswertung und der Datenvisualisierung auch selbst immer weiter automatisiert – augmented Analytics nennt Gartner das von nun an.

Dabei wird auch die Entwicklung von neuen KI-Algorithmen immer weiter automatisiert und mit Hilfe von KI-Systemen beschleunigt. Bis 2022 sollen diese Methoden bereits in 40 Prozent der Entwicklungsprojekte Realität sein. Damit verbunden ist freilich ein ungeheurer Bedarf an KI-Entwicklern, die zusammen mit Datenanalysten die Entwicklerteams begleiten. Man darf sich fragen, wie in der Zukunft dieser spezielle Fachkräftebedarf gedeckt wird.

Künstliche Intelligenz wird auch ins Edge Computing eingreifen. Mit der Edge rückt die Cloud wieder stärker an den eigentlichen Ort der Prozesse und Datenentstehung. Man könnte fast sagen, dass hier nach der Zentralisierung Richtung Cloud wieder ein Stück Dezentralisierung kommt, über die die Latenzzeiten – also die Wartezeit, bis die Cloud-Services über die 5G-Bandbreiten reagiert haben – verkürzt werden soll. Allerdings sollen spezielle KI-Chips auch dafür sorgen, dass diese peripheren Endgeräte smart genug sind, um auf Cloud-Services zu verzichten.

Dass mehr Rechenpower und KI-Cleverness auch wieder näher an den eigentlichen Ort des Geschehens rücken soll, findet laut Gartner auch seinen Grund in dem weiter zunehmenden Einsatz von Augmented Reality. Die virtuellen und begleitenden Realitätswelten benötigen nämlich enorme Rechnerleistung, um überhaupt zeit- und realitätsnah entstehen zu können. Das ganze wird dann mehr und mehr unsere Smart Spaces, wie Gartner den Sammelbegriff für Smart Homes, Smart Cities und Smart Factories nennt, beeinflussen.

Demzufolge wird sich ab 2019 eine Diskussion über digitale Ethik und die Bedeutung (wenn nicht den Verbleib) der Privatsphäre eröffnen, die die Rolle des Menschen in dieser KI-fizierten Zukunft untersucht. Vielleicht aber überlassen wir die Entscheidung über richtig und falsch dann schon den Quantum Computern, die auch komplexeste Wechselwirkungen zwischen Maschinen, Materialien, Methoden und Menschen simulieren können. Vielleicht empfiehlt uns Gartner dann, in die Gegenwart zurückzukehren – als Re-Dezentralisierung, Re-Despezialisierung, Re-Delinearisierung und zuletzt Regression.

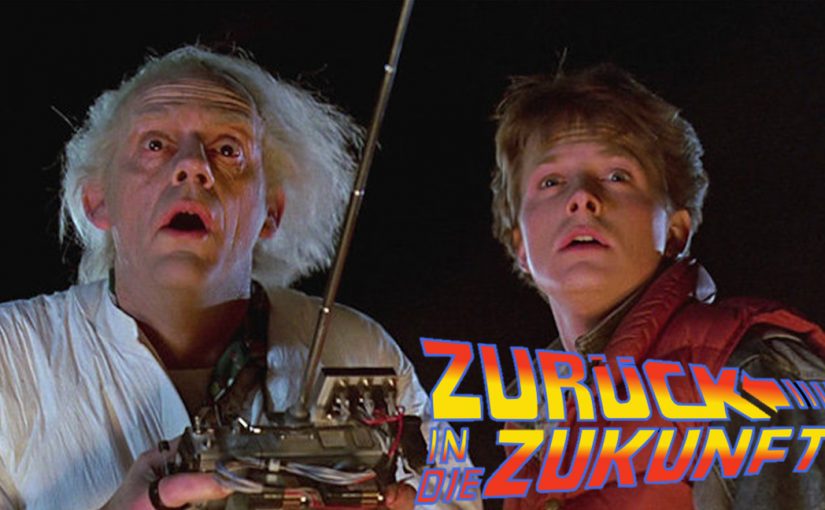

* Das Foto wurde der Steven-Spielberg-Produktion „Zurück in die Zukunft“ entnommen.