In regelmäßigen Abständen liefert uns die Gartner Group Megatrends und Zukunftstechnologien frei Haus, die uns ein anregendes Kribbeln im Rückgrat verursachen, weil sie so unfassbar sind, dass wir nicht glauben können, noch zu Lebzeiten mit ihnen konfrontiert zu werden. Und in der Tat bedeutet dieser Blick in die Kristallkugel der Informationstechnologie auch nach Gartners eigener Definition, dass wir uns nach kurzem Schaudern auch gut wieder den eigentlichen Herausforderungen des digitalen Wandels zuwenden können.

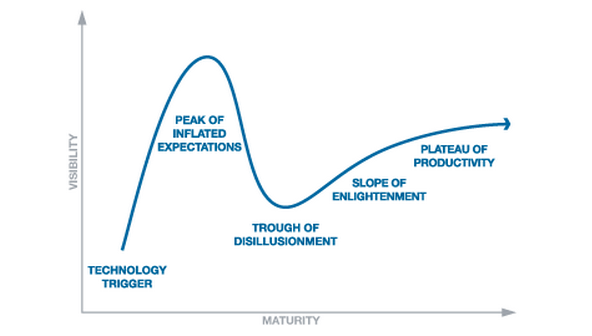

Denn der Hype Cycle, der den Technologieprognosen zugrunde liegt, ist von Gartner im Jahr 2000 in fünf Phasen unterteilt worden: Nach dem Auftauchen der Innovation (I) folgt der Gipfel der überzogenen Erwartungen (II), die schließlich ins Tal der Desillusion (III) führen, worauf sich der sanfte Anstieg der Erleuchtung und realistischen Einschätzung (IV) anschließt, der schließlich auf der Hochebene des produktiven Einsatzes (V) ankommt. Demnach sind die Megatrends und Zukunftstechnologien stets in der Phase der überzogenen Erwartungen.

Aber auch im Hype erkennt man die Richtung, in die sich die Informationstechnologie in einem Zeitraum von fünf bis zehn Jahren bewegen wird. Und der Hype der Stunde schreibt sich mit AI: „Artificial Intelligence Everywhere“ nennen die Gartner-Analysten das, was uns aus neuronalen Netzen und regelbasierten Systemen blüht. Denn während die künstliche Intelligenz auf Servern irgendwo in der Cloud residiert, nutzen alle möglichen mobilen und stationären Anwendungen die AI-Services über APIs – nahtlos und unmerklich.

Und gleich dürfen wir auch wieder neue Hype-Vokabeln lernen:

- Artificial General Intelligence ist die Allgemeinverfügbarkeit dieser Dienste, die der menschlichen Intelligenz noch recht nahe kommen soll.

- Deep Learning oder Machine Learning beschreibt die Fähigkeit, mit Hilfe neuronaler Netze aus den Aktivitäten für die Zukunft zu lernen. Einsatzgebiete sind Bild-, Sprach- und Gesichtserkennung.

- Deep Reinforcement Learning wiederum erweitert die Lernmechanismen um Methoden zur Verstärkung (Belohnung) und Schwächung (Bestrafung) von Impulsen. So wird ein System animiert, sich so weiterzuentwickeln, dass der Anteil an Belohnung möglichst 100 Prozent ist.

- Cognitive Computing schließlich beschreibt die Simulation menschlicher Denkprozesse, wie sie heute pionierhaft durch IBM Watson erreicht wird. Dabei wird eine Kombination bereits bewährter Technologien angewendet: Data Mining, Mustererkennung, die Verarbeitung natürlicher Sprache und die Nachahmung menschlicher Fähigkeiten wie Lernen, Erinnern, Argumentation und Problemlösung.

Da AI-basierte Systeme nicht nur menschliches Verhalten simulieren, sondern auch menschliches Verhalten zu deuten verstehen, wird die Schnittstelle zwischen Mensch und Maschine immer komfortabler – jedenfalls für den Menschen. Gartner hat auch dafür einen neuen Hype-Text erfunden: Transparently Immersive Experience. Gemeint ist, dass Maschinen immer mehr in die Ausdruckwelt des Menschen eindringen, ihn verstehen und sich verständlich machen. Dazu tragen nicht nur AI-Funktionen wie Sprach- und Gestensteuerung bei, sondern auch neue Darstellungsformen wie Virtual beziehungsweise Augmented Reality oder die Möglichkeit, von praktisch jedem physischen Gegenstand einen digitalen Zwilling zu erzeugen, der Simulationen, Modifikationen, Wartung, Erweiterungen und Weiterentwicklungen erlaubt, ohne dass das Original dafür auseinandergenommen oder auch nur vom Netz oder aus dem Arbeitsprozess genommen werden muss.

Und schließlich glaubt Gartner, dass sich digitale Plattformen für Alles und Jedes in der Cloud etablieren werden. So wird es beispielsweise unter der Wortschöpfung Edge Computing zu Vorschalt-Systemen kommen, die das massive Datenvolumen aus dem Internet der Dinge bündeln, ehe AI-Systeme mit den Daten konfrontiert werden. So ist bereits heute klar, dass ERP-Systeme ein Manufacturing Execution System benötigen, um mit dem gigantischen Datenvolumen aus dem Internet der Dinge fertig zu werden. Ähnliche Plattformen wird es auch in anderen Bereichen geben – beim autonomen Fahren, beim Smart Farming, bei der Telemedizin oder bei Sicherheitssystemen.

Ach ja: 5G, der um das Zehnfache gegenüber der heutigen LTE-Technologie schnellere Mobilfunkstandard, gehört laut Gartner ebenfalls zu den wichtigsten Zukunftstechnologien, auch wenn nach Einschätzung der Gartner-Analysten im Jahr 2020 erst drei Prozent der Anbieter diese zehn Gigabit pro Sekunde schnelle Bandbreite im Programm haben werden. Aber bei allem HAIpe um künstliche Intelligenz – da lassen wir natürlich die neue Bundesregierung nicht vom Haken.